Historia kart graficznych

Pierwsze PC IBM oraz karty graficzne MDA

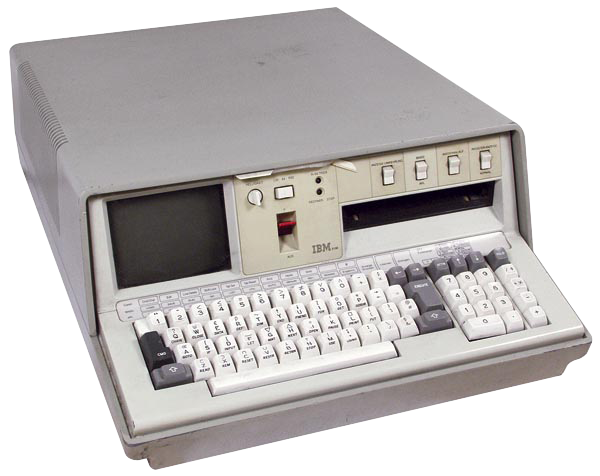

Pierwsze pecetowe karty graficzne powstały w roku 1975, kiedy to firma IBM rozpoczęła sprzedaż swojego pierwszego komputera osobistego, IBM 5100. Urządzenie miało 16 kB pamięci operacyjnej, dane pobierało z taśmy, a z użytkownikiem komunikowało się wyświetlając na monitorze koślawe litery w formie 16 wierszy, po 64 znaki w każdym wierszu. IBM 5100 kosztował w tamtych czasach 9000 USD.

12 sierpnia 1981 pojawił się następca 5100, komputer IBM 5150 Personal Computer. Był to pierwszy komputer firmy IBM z procesorem Intela - szesnastobitowym 8088. Cechował się otwartą architekturą - umożliwiał instalację dodatkowych komponentów w postaci kart rozszerzeń ISA.

IBM 5150 został wyposażony w zaawansowany adapter graficzny, mający postać karty ISA: MDA (Monochrome Display Adapter). MDA wyświetlał obraz o rozdzielczości 720x350 punktów, jednak pracował tylko w trybie tekstowym. Wyświetlał na ekranie 25 wierszy tekstu, w każdym po 80 znaków.

MDA wyświetlał wyłącznie obraz dwukolorowy - biało-czarny, zielono-czarny lub bursztynowo-czarny (zależnie od zastosowanego monitora). Udostępniał specjalne efekty dla tekstu, jak rozjaśnienie oraz podkreślenie. Dane o wyświetlanym tekście MDA przechowywał w 4 kB własnej pamięci.

Pierwsza kolorowa grafika

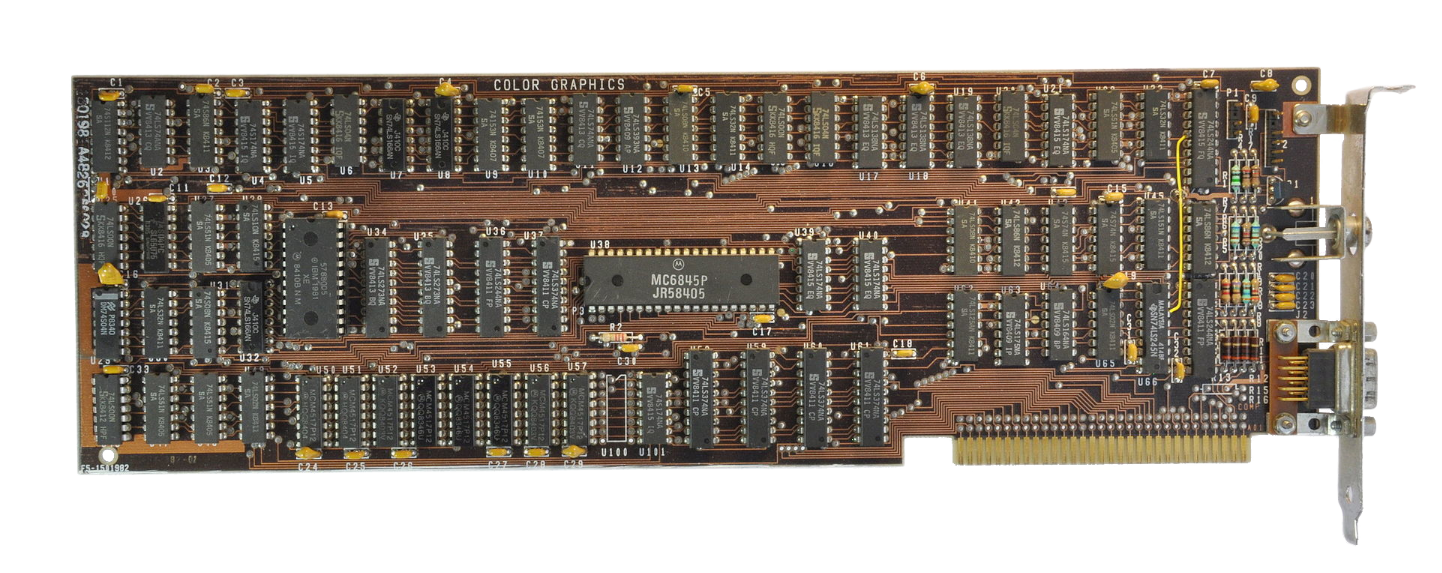

Po premierze pierwszego peceta, IBM zaproponował swoją pierwszą "kolorową" kartę graficzną: CGA (Color Graphics Adapter), która, prócz tekstowego, oferowała także tryby graficzne. Urządzenie miało czterokrotnie więcej pamięci od MDA - 16 kB. Najpopularniejszy tryb graficzny to 320x200 przy czterech kolorach: białym, czarnym, różowym i jasnoniebieskim lub źółtym, czarnym, zielonym i czerwonym.

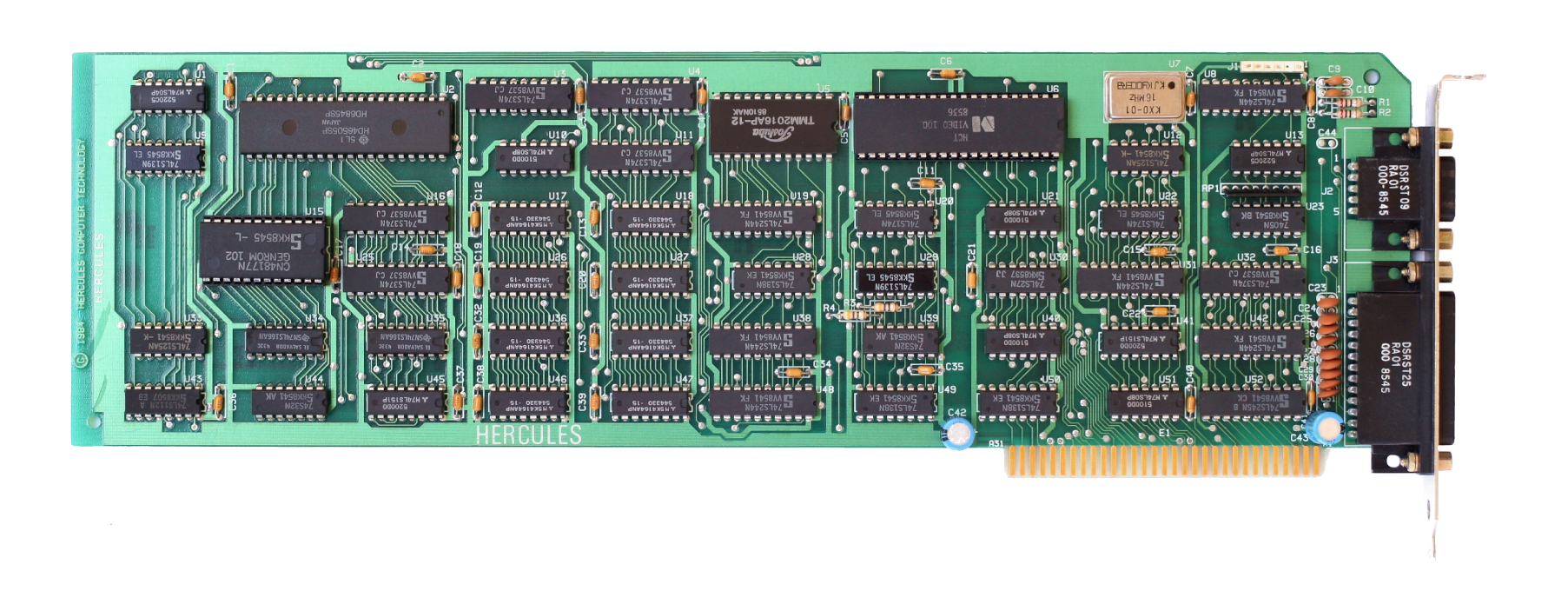

W 1982 roku firma Hercules Computer Technology wprowadziła na rynek słynny adapter graficzno-tekstowy: Hercules Graphics Card (HGC), znany jako po prostu "Hercules". Udostępniał tryb tekstowy zgodny z MDA (80x25 znaków) oraz wysokorozdzielczy, monochromatyczny tryb graficzny 720x348 punktów.

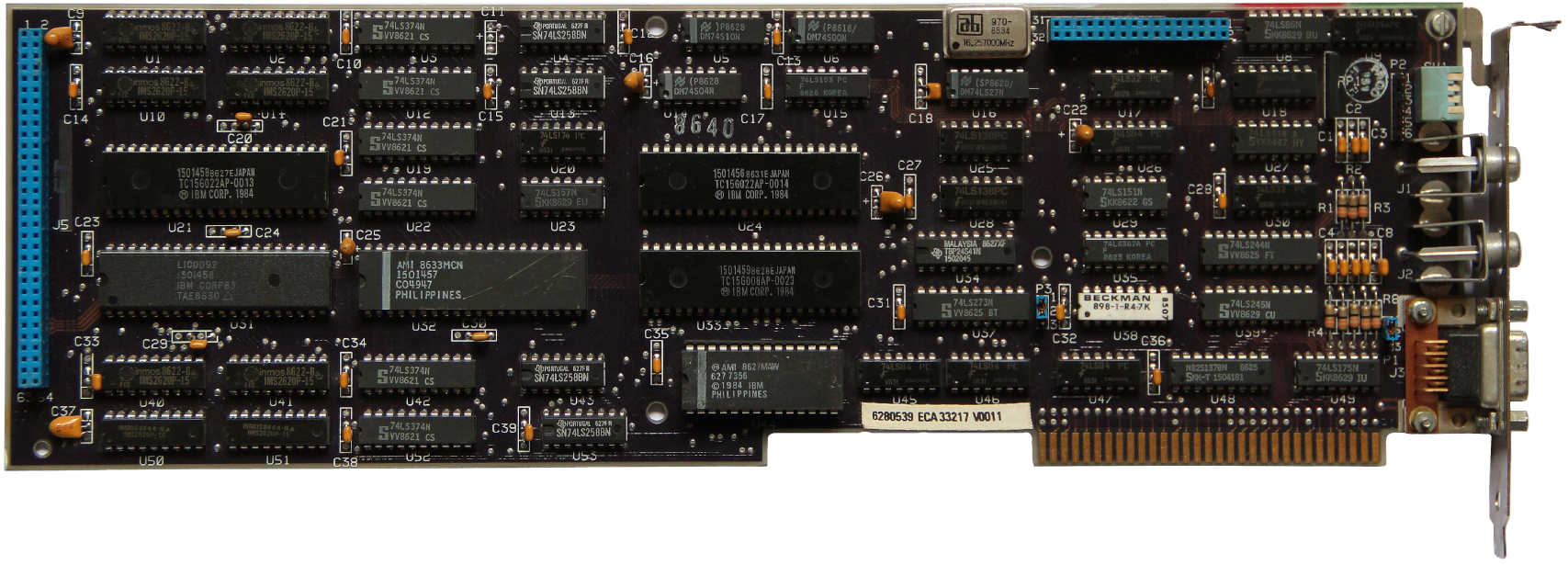

Dwa lata później IBM zaprezentował pierwszą, naprawdę przyzwoitą kartę graficzną: EGA (Enhanced Graphics Adapter) z 64 kB pamięci, rozszerzalnej do 256 kB. EGA była zgodna zarówno z CGA, jak i MDA oraz wprowadziła dwa nowe tryby graficzne: 320x200 i 640x350, przy których potrafiła wyświetlić jednocześnie aż 16 kolorów (z 64-kolorowej palety).

VGA

Rok 1987 można uznać za przełomowy. Wtedy to ukazała się pierwsza karta graficzna VGA (Video Graphics Array), przeznaczona dla standardowej magistrali ISA. Była zgodna wstecz ze wszystkimi poprzednimi standardami: MDA, CGA i EGA i miała 256 kB lokalnej pamięci. Wyprowadzała analogowy sygnał wideo, dzięki czemu uzyskiwała znacznie większą paletę kolorów, niż cyfrowe EGA i CGA. Oferowała tryb tekstowy 80x25 znaków, oraz dwa nowe tryby graficzne: 320x200 przy 256 kolorach oraz 640x480 przy 16 kolorach.

Szybko możliwości VGA okazały się niewystarczające. Niezależni producenci zaczęli wytwarzać własne karty graficzne, zgodne na poziomie sprzętowym z VGA, jednak wprowadzające nowe tryby graficzne: 800x600, 1024x768 lub 1280x1024. Prostsze modele, które miały tylko 256 kB pamieci, wyświetlały tryb 640x480 w 256 kolorach, zaś pozostałe tryby o wyższej rozdzielczości wyświetlały jedynie w 16 lub nawet tylko dwóch kolorach. Mocniejsze karty, z 512 a nawet 1024 kB pamięci, potrafiły wyświetlić nawet rozdzielczość 1024x768 w 256 kolorach, a 1280x1024 przy 16 kolorach.

Wszystkie karty określone zostały przez swych producentów ogólnym mianem SVGA (Super VGA). Poza trybami VGA, SVGA nie był standardem: aplikacja napisana dla karty SVGA firmy Oak nie działała poprawnie na karcie SVGA firmy Trident czy Western Digital. By zaradzić temu problemowi, najwięksi producenci kart graficznych i monitorów utworzyli organizację VESA (Video Electronics Standards Association). VESA rozpoczęła proces standardyzacji wszystkich kart graficznych, by umożliwić im zgodność ze sobą. Powstały rozszerzenia VESA BIOS Extension, opisujące dodatkowe tryby graficzne.

VLB i PCI

Następnym krokiem rozwoju kart graficznych była zmiana ich magistrali. 16-bitowa magistrala ISA, z której korzystały wszystkie karty graficzne do SVGA, szybko okazała się niewystarczająca. Jej największa przepustowość, ok. 16 MB/s, to zbyt mało dla zastosowań graficznych.

VESA rozpoczęła pracę nad rozszerzeniem magistrali ISA do 32-bitów, dzięki czemu zwiększona miała być jej przepustowość. Tak powstała magistrala VESA Local Bus (VLB), której zaletą - tak się przynajmniej w tamtym czasie wydawało - była możliwość instalacji starszych kart ISA.

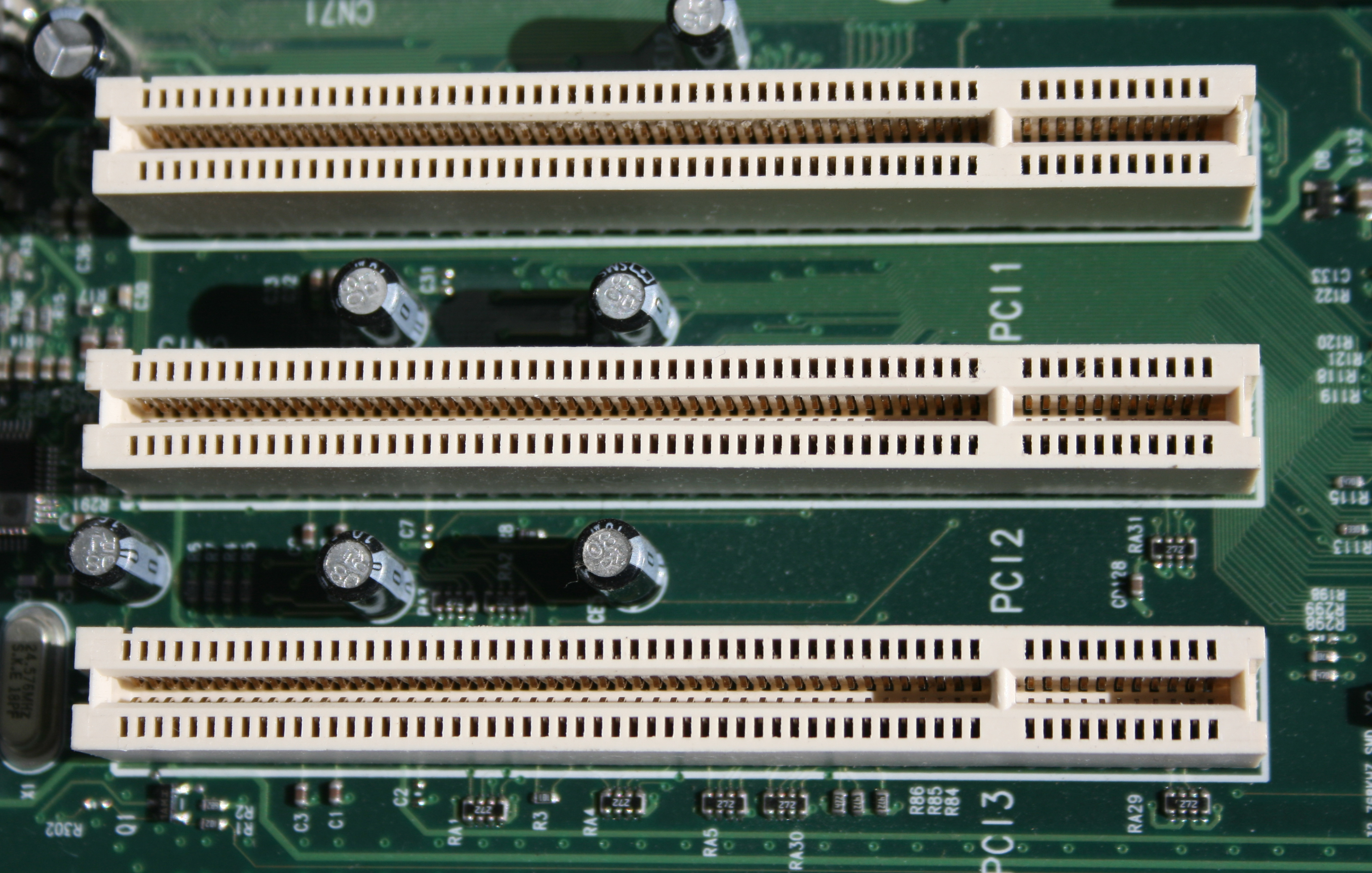

W tym czasie Intel rozpoczął pracę nad własną magistralą, PCI (Peripheral Component Interconnect), zupełnie niekompatyblną z ISA (w przeciwieństwie do VLB). PCI to 32-bitowa magistrala zgodna ze standardem Plug&Play, oferująca przepustowość rzędu 132 MB/s.

W pojedynku PCI z VLB sukces wróżono magistrali VESA, a jednak ku zaskoczeniu wielu bitwę wygrała szyna PCI. Ta przetrwała zresztą do dnia dzisiejszego, a złącza PCI znajdziemy praktycznie na wszystkich współczesnych płytach głównych.

Producenci kart graficznych zaczęli prześcigać się osiągami swoich akceleratorów. Kolejne karty miały coraz więcej pamięci, 32-bitowe układy graficzne zostały zastąpione 64-bitowymi, poszerzano paletę funkcji umożliwiających kartom wspomaganie w rysowaniu grafiki.

Trzeci wymiar

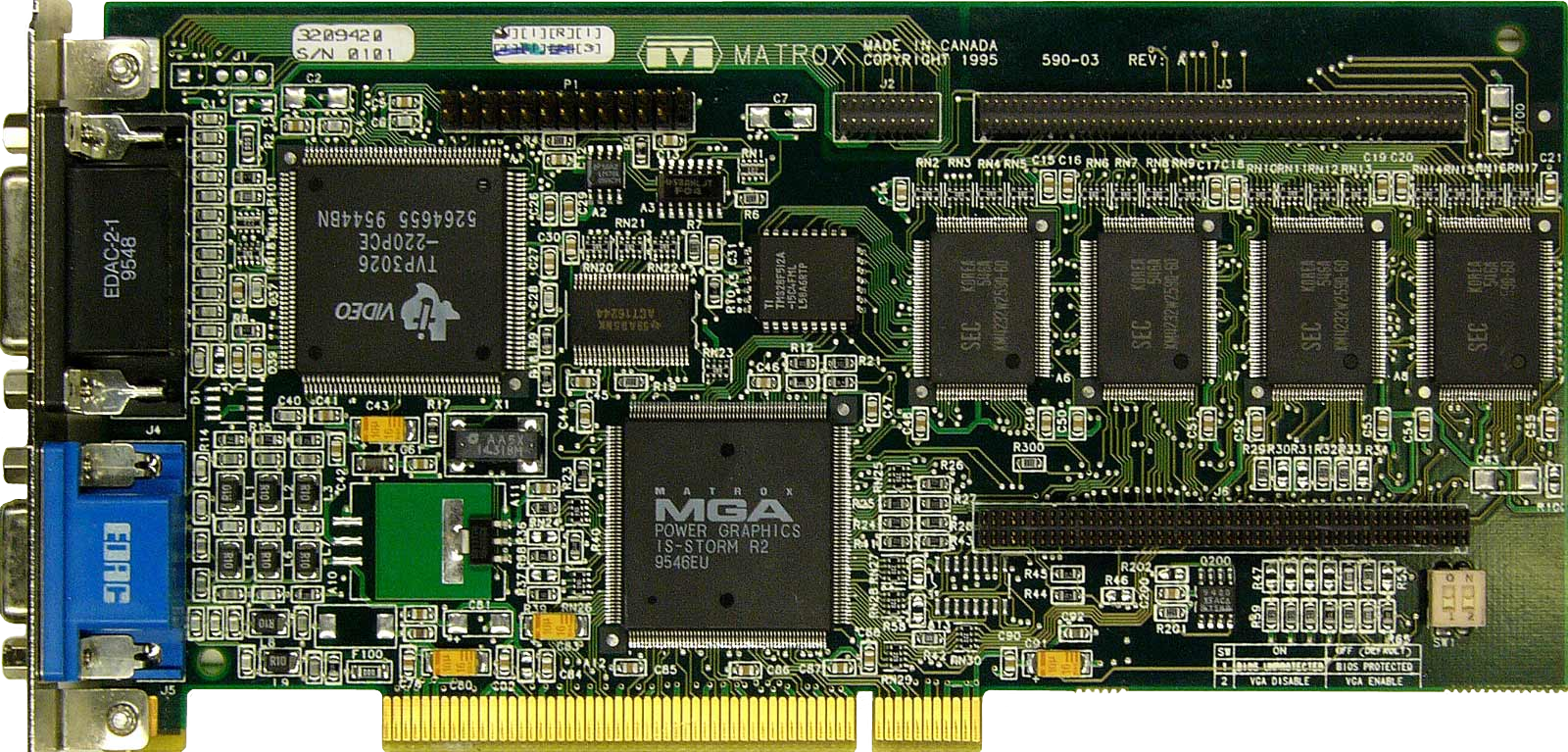

Jedną z pierwszych kart graficznych z funkcjami wspomagającymi grafikę 3D, była Matrox Millennium. Zdolna była tworzyć w obrębie własnej pamięci dodatkowy bufor trzeciej współrzędnej Z. Dodatkowo Millennium potrafiła cieniować obiekty trójwymiarowe metodą Gourauda.

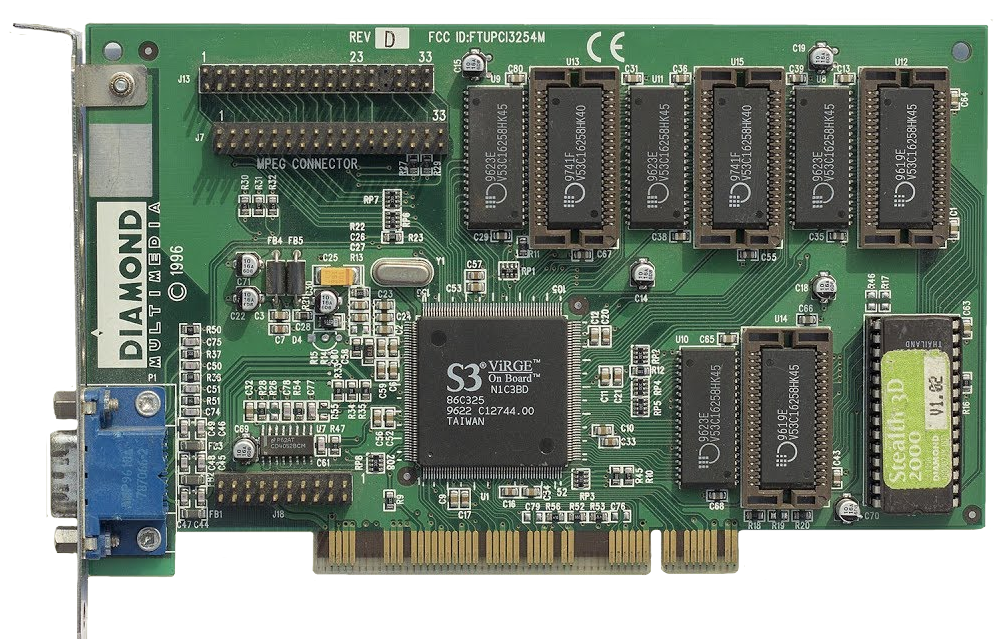

Pierwszy tani układ graficzny 2D/3D, ViRGE (Video and Rendering Graphics Engine), wprowadziła pod koniec

1995 roku firma S3. Oferował on możliwości akceleracji grafiki 2D na poziomie Matroxa Millennium i

oferował funkcje filtrowania dwuliniowego. Prócz tego ViRGE tworzył grafikę trójwymiarową

z 16-bitową paletą kolorów i potrafił dodawać efekty atmosferyczne (mgła, dym). Niestety zamiast przyspieszać

grafiki 3D potrafił ją nawet spowalniać, więc szybko przylgnęło do niego miano "deceleratora". Mimo to właśnie

ViRGE jako pierwszy wprowadził trzeci wymiar w przystepnej cenie.

W 2000 roku S3 Graphics zostało wykupione przez VIA.

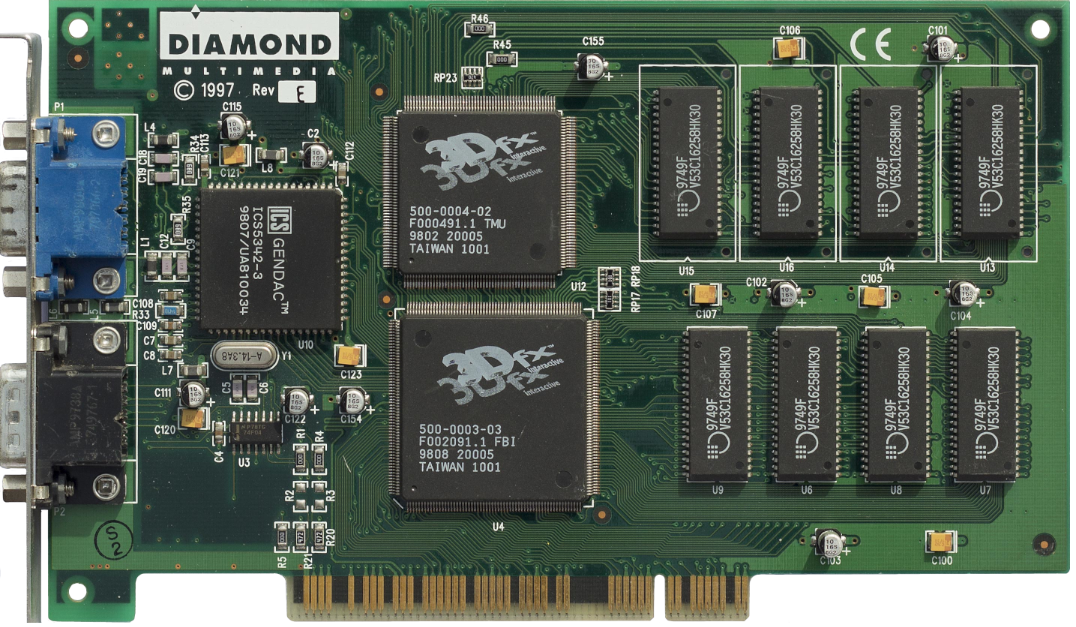

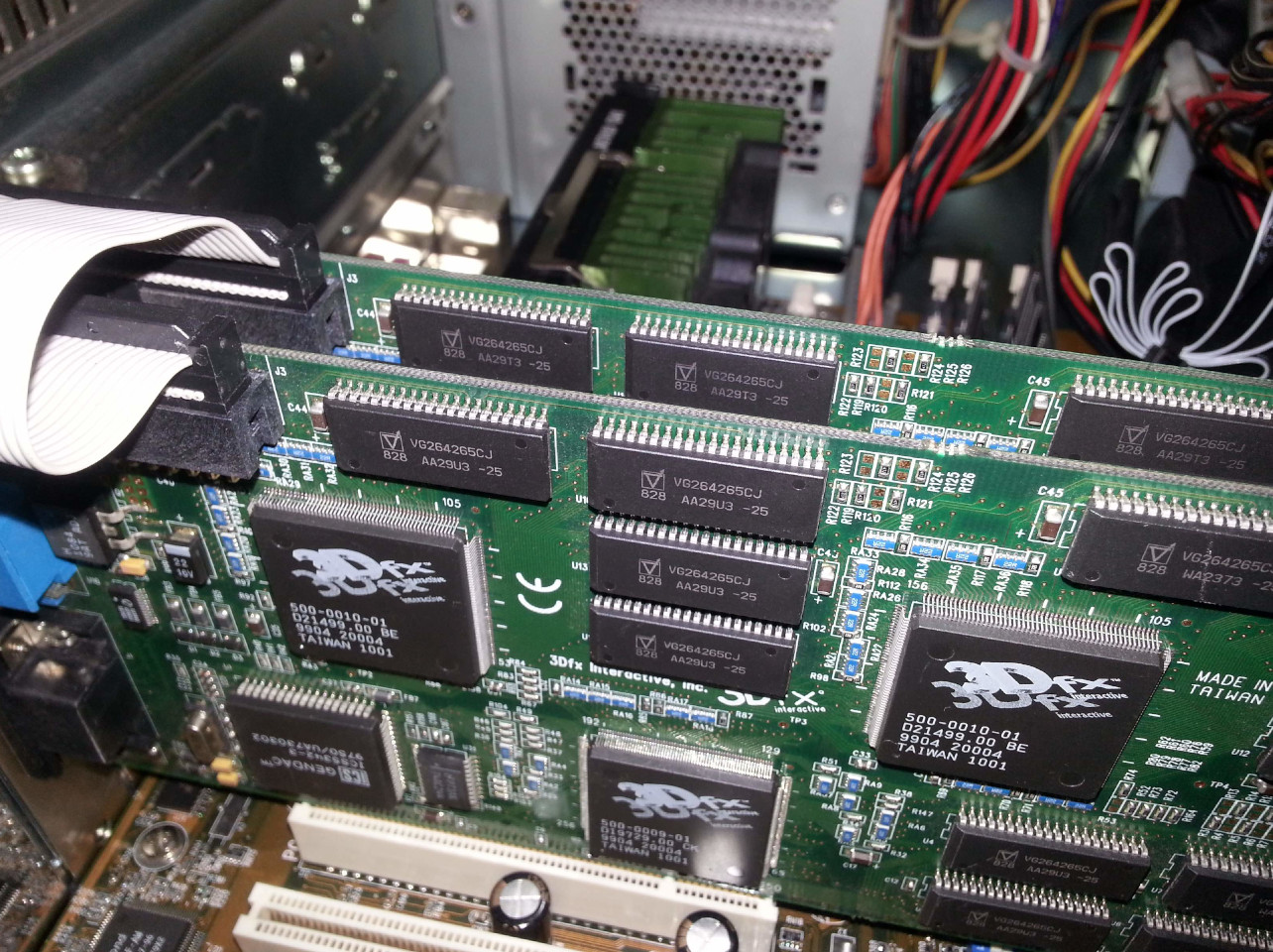

3Dfx Voodoo

Rok 1996 fani komputerów zapamiętali jako pojedynek układów PowerVR korporacji NEC/VideoLogic oraz Voodoo Graphics mało wówczas znanej firmy 3Dfx. Chociaż początkowo wróżono 3Dfx porażkę (układ PowerVR był bardziej zaawansowany technologicznie), to jednak ostatecznie pojedynek wygrał właśnie 3Dfx Voodoo Graphics. Miał postać karty rozszerzeń PCI. Znajdowały się na niej dwa układy graficzne: 3Dfx TexelFX i 3Dfx PixelFX, a także 4 MB pamięci EDO DRAM. Voodoo wspomagał jedynie grafikę trójwymiarową, zatem do pracy wymagał obecności w komputerze także zwykłej karty graficznej zgodnej z VGA.

Voodoo Graphics kilkukrotnie przyspieszał szybkość generowania grafiki i oferował bardzo dobrą jak na ówczesne czasy jakość obrazu i podniósł rozdzielczość w grach z 320x200 do 640x480.

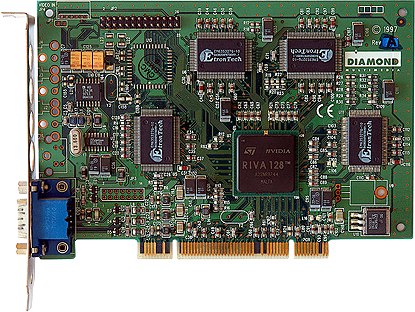

RIVA 128, Voodoo2 i SLI

Na początku 1997 NVIDIA, o której wówczas nadal było cicho, zaprezentowała układ RIVA 128 (Realtime Interactive Video and Animation), który zatrząsł rynkiem kart graficznych. Stanowił zintegrowany akcelerator grafiki 2D (zgodny z VGA) oraz 3D. W testach Direct3D był nawet szybszy od Voodoo, jednak nie oferował aż tak dobrej jakości obrazu.

RIVA 128 była układem, który rozpoczął trwającą przez kilka lat wojnę między NVIDIĄ a 3Dfx z przegraną ze strony 3Dfx.

W 1998 roku na półki sklepowe trafiły akceleratory 3Dfx Voodoo2, dostępne w dwóch wersjach, z 8 i 12 MB pamięci. Pojedyncza karta Voodoo2 była dwukrotnie szybsza od RIVY 128 w grach 3D. Dodatkowo wydajność Voodoo2 można było podwoić poprzez instalację dwóch kart tego typu w komputerze i połączenie ich w tzw. tryb SLI (Scan Line Interleave). Akronimu "SLI" używa obecnie NVIDIA na określenie pracy kilku akceleratorów z układami GeForce.

GeForce 256 był pierwszym konsumenckim układem graficznym, który został wzbogacony o procesor zajmujący się oświetleniem i transformacjami geometrycznymi (T&L Engine - od "Transform & Lighting Engine). Wraz z GeForce 256 zadebiutował termin GPU (Graphics Processing Unit), czyli Jednostka Przetwarzania Grafiki, analogicznie do CPU (Central Processing Unit), którym określa się procesor komputera.

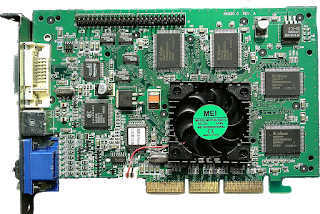

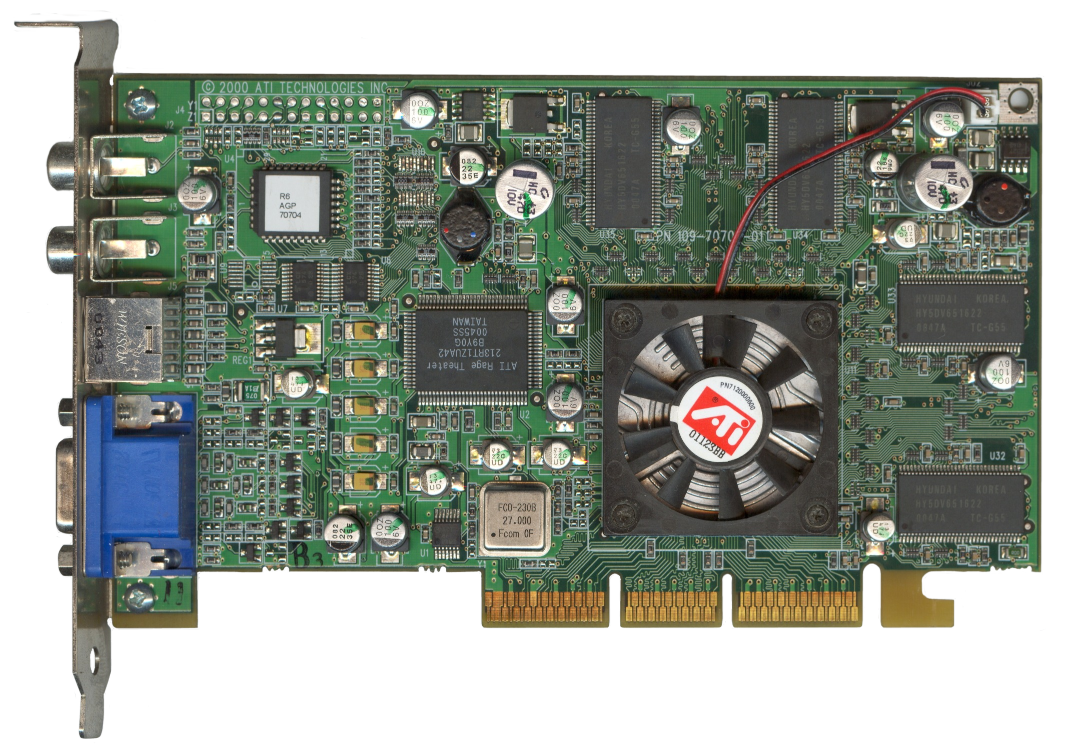

Pierwsze Radeony i upadek 3dfx

Na początku 2000 roku ATI zaprezentowała układ o kodowej nazwie R100 (znany też jako Rage 6), następcę popularnego chipu Rage 128. Układ otrzymał nazwę Radeon 256 (później przyrostek "256" porzucono, by nie mylić układu z GeForce 256) i był pierwszym chipem ATI oferującym sprzętową jednostkę T&L. Dział marketingu ATI starał się unikać użytego przez NVIDIĘ określenia GPU i próbował wprowadzić własny akronim dla nowego układu - VPU (Visual Processing Unit).

Radeon 256 był pierwszym układem noszącym nazwę Radeon. Ta nazwa również przetrwała do dziś. Nowy chip ATI trafił początkowo na karty z najwyższej półki, dostępne w dwóch wariantach - z 32 MB pamięci DDR i 64 MB pamięci DDR. Układ stosowany na tych kartach, po wspomnianym usunięciu przyrostka "256", zaczęto określać mianem Radeon DDR. W lecie 2000 ATI wprowadziło także karty Radeon SDR, z tańszymi pamięciami SDR.

Rok 2000 był tragicznym dla 3dfx. Firma miała problemy z wprowadzeniem na rynku układu Rampage (nad którym pracowała od 1998 roku) i na jesieni jasne już było, że producent Voodoo upada. Wreszcie 3dfx wnieśli o upadłość firmy. W grudniu własności intelektualne oraz część pracowników 3dfx (w tym grupa pracująca nad Rampage) zostały przejęte przez firmę NVIDIA.

PCI Express

W wakacje 2004 Intel przewrócił rynek pecetów do góry nogami. Wprowadził nowe chipsety i beznóżkowe procesory Pentium 4 (z podstawką LGA775). Na nowych płytach pod procesory Intela pojawiły się podstawki pod pamięci DDR2, a także nowa magistrala - PCI Express.

PCI Express ma zastąpić przede wszystkim przestarzałą szynę PCI, ale ze względu na bardzo dobre parametry, także dedykowaną kartom graficznym AGP. PCI Express x16 udostępnia przepustowość dwukrotnie większą niż najszybsza odmiana AGP 8x.

W 2004 roku pojawiły się też pierwsze karty PCI Express, jak Radeon X800 XT, Radeon X800 Pro, GeForce PCX 5900 czy GeForce PCX 5750.

Pod koniec września 2007 na półki sklepowe trafiły płyty główne z nowym chipsetem Intel X38, pierwszym, który obsluguje magistralę PCI Express 2.0.